〒650-0035

兵庫県神戸市中央区浪花町64 三宮電電ビル 5階

目次

これまでに、 LM Studio を用いて gpt-oss をローカルLLMとしてを動かす情報 について発信してきました。

今回は Ollama を用いて手軽に手元の環境でローカルLLMを動かす方法について、先日OpenAI社が公開した gpt-oss-20b を用いて試してみます。

ディジョンはお客様のクラウド環境やオンプレ環境で、ローカルLLMをセキュアに動かす「 ローカルLLM構築サービス 」を提供しています。

Ollamaは、高性能なオープンソース大規模言語モデル(LLM)を、手元のPCや社内サーバーで手軽に起動・管理できるローカルAIプラットフォームです。

プライバシー重視の企業や個人に適しており、LLMとのやり取り自体はインターネット非依存かつ機密性の高いAI活用を実現できます。

対応モデルには、

などがあり、先日このラインナップに、OpenAI社が公開した gpt-oss が追加されました。

まとめ

類似サービスには先日記事を公開した LM Studio や vLLM などがあります。

Ollama の最大の特徴は LM Studio に近く、手元のパソコンやサーバーで手軽に試しやすいという点です。CLIツールだけではなく、GUI版の提供もあり、コマンド操作に慣れない人でも画面上の操作で簡単にローカルLLMを試すことができます。

それに対する LM Studio は CLI の提供はなく、手軽にローカルLLMを動作させることに特化したツールである点が特徴です。

そして vLLM はパフォーマンスに最適化されており、重いモデルを高いパフォーマンス(特に実行速度)で動かす能力が特徴です。使い道としては、Ollama や LM Studio で手軽に検証して実際に本番環境でローカルLLMを構築しようというケースに最適化されたツールです。

Ollama と LM Studio との比較記事を公開していますので、詳しくはこちらもご覧ください。

Ollama vs LM Studio ローカルLLMツールの特徴・使いやすさ・選び方ガイド

Ollama は LM Studio と同様に、モデルのダウンロードなどにおいてはインターネット環境を使用します。

一度ダウンロードしたモデルについては、その後はインターネットへの接続なしに、メッセージのやり取りができるので、データがどこかに流出するという懸念はありません。

Ollama はアプリのインストールと起動が完了した段階で、 localhost のポート 11434 でサーバーが起動しています。

モデルダウンロード後にここへ必要なリクエストを送信することで、OpenAIのChat Completion API互換のローカルAPIとしても動きます。

この辺りの仕組みも含めて、 LM Studio と同様のようなアプリケーションとなっています。

多くの企業では、顧客情報や機密資料を外部のクラウドAIに送信することに対して強い懸念があります。

Ollamaを使えば、社内サーバーや閉域ネットワーク内でモデルを稼働させられるため、情報漏えいリスクを最小化できます。

例えば、社内マニュアルの検索や、契約書の要約・比較といったタスクを安全に自動化可能です。

ローカル環境で直接モデルを動かせるため、APIの呼び出し制限や料金を気にせずに試作を繰り返せます。

フロントエンド・バックエンド両方のエンジニアが同じ環境でテストできるため、開発サイクルの短縮に貢献します。

特にOllamaのOpenAI互換APIは、既存のChatGPT向けコードをほぼそのまま流用できる点が大きな利点です。

工場・病院・官公庁など、一部の業務環境ではインターネット接続が制限されているケースがあります。

こうした場所でも、Ollamaでモデルを事前ダウンロードしておけば、オフライン状態で推論を実行できます。

結果として、現場作業員や研究員がネット接続を待たずにAIの補助を受けられます。

Ollamaは標準モデルだけでなく、LoRAやFine-tuningを行ったカスタムモデルもローカルで動かせます。

これにより、業界固有の専門用語や社内ルールを反映した独自AIを構築し、全社員が同一品質の支援を受けられます。

また、モデルの切り替えや更新も社内で完結するため、セキュリティ監査や運用管理も容易です。

GPT-OSS はOpenAI社が発表したオープンウェイトなLLMであり、 gpt-oss-20b と gpt-oss-120b の2つのモデルが提供されています。

Meta Llama や Google Gemma などが、オープンLLMの先行プレイヤーとして存在していましたが、 gpt-oss が発表されたことにより、 OpenAI の o3-mini や o4-mini レベルのモデルが使えるようになりました。

これによってローカル環境や自社のサーバーでLLMを動かすときの最有力の選択肢になってきています。

gpt-oss について詳しくは OpenAI GPT-OSS の概要と性能を確認した記事 を公開していますので、ぜひご参照ください。

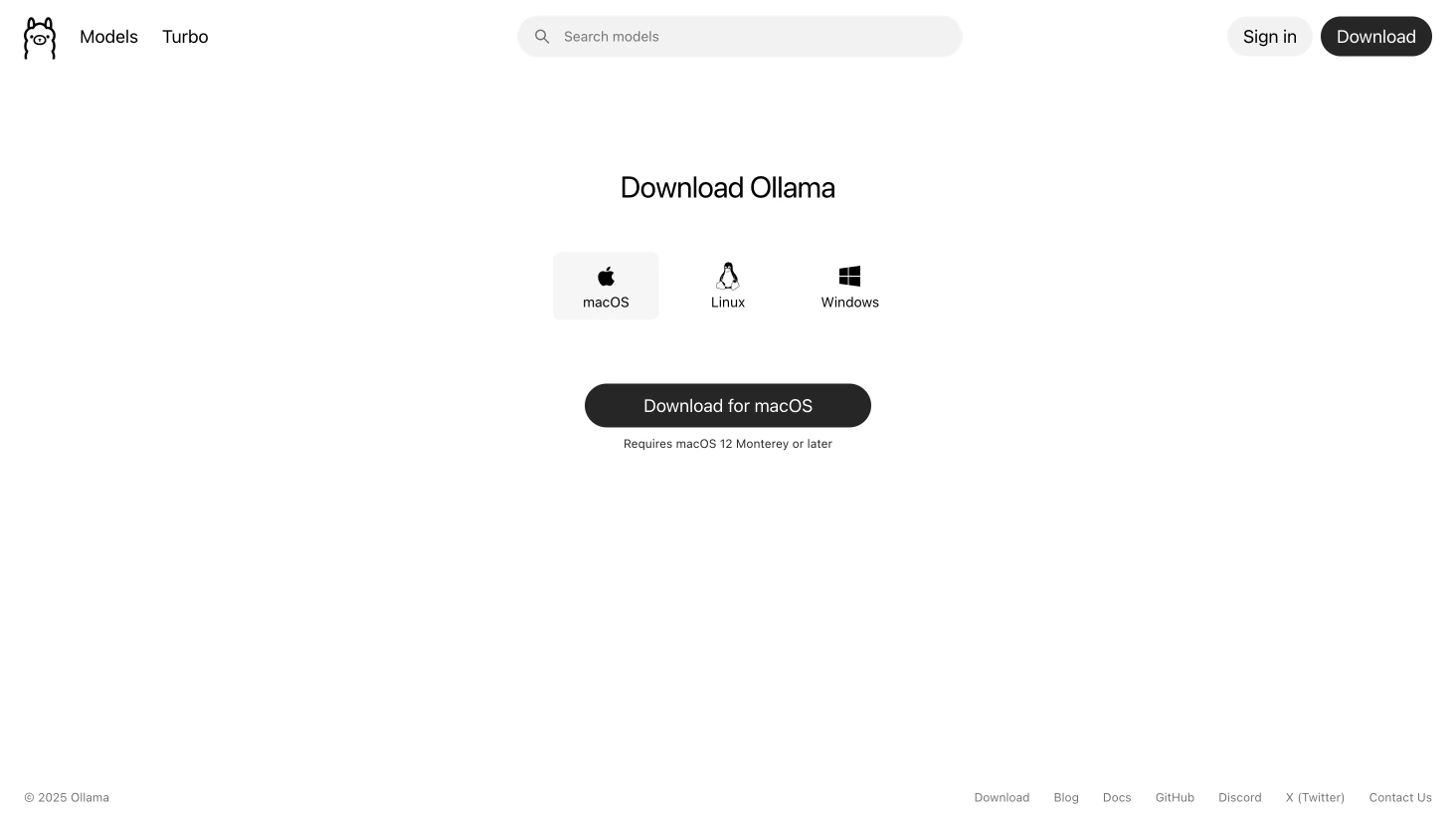

Ollama は 公式のダウンロードページ からダウンロード・インストールできます。

対応OSは、 Windows / Mac / Linux であり、それぞれに合わせたバージョンのアプリをインストールしてください。

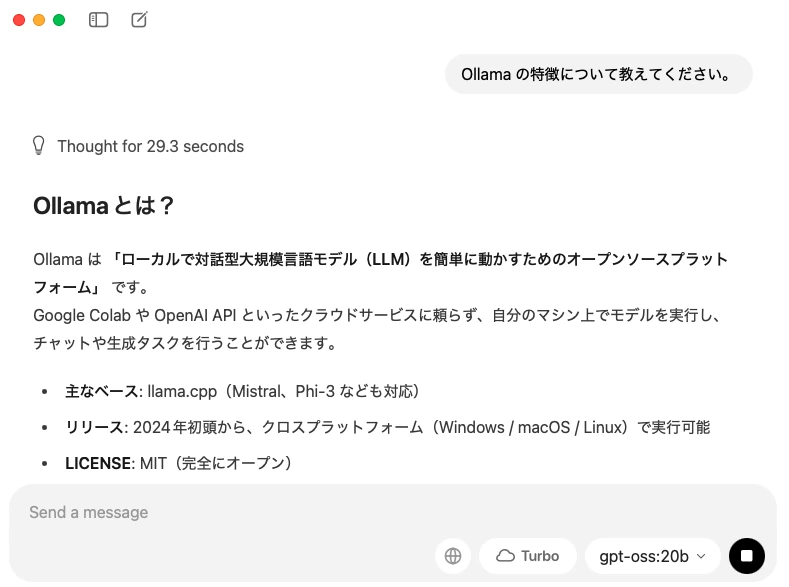

インストールが完了すると、CLIとGUIの両方のインストールが完了した状態になります。アプリを起動すると以下のような画面が表示されます。

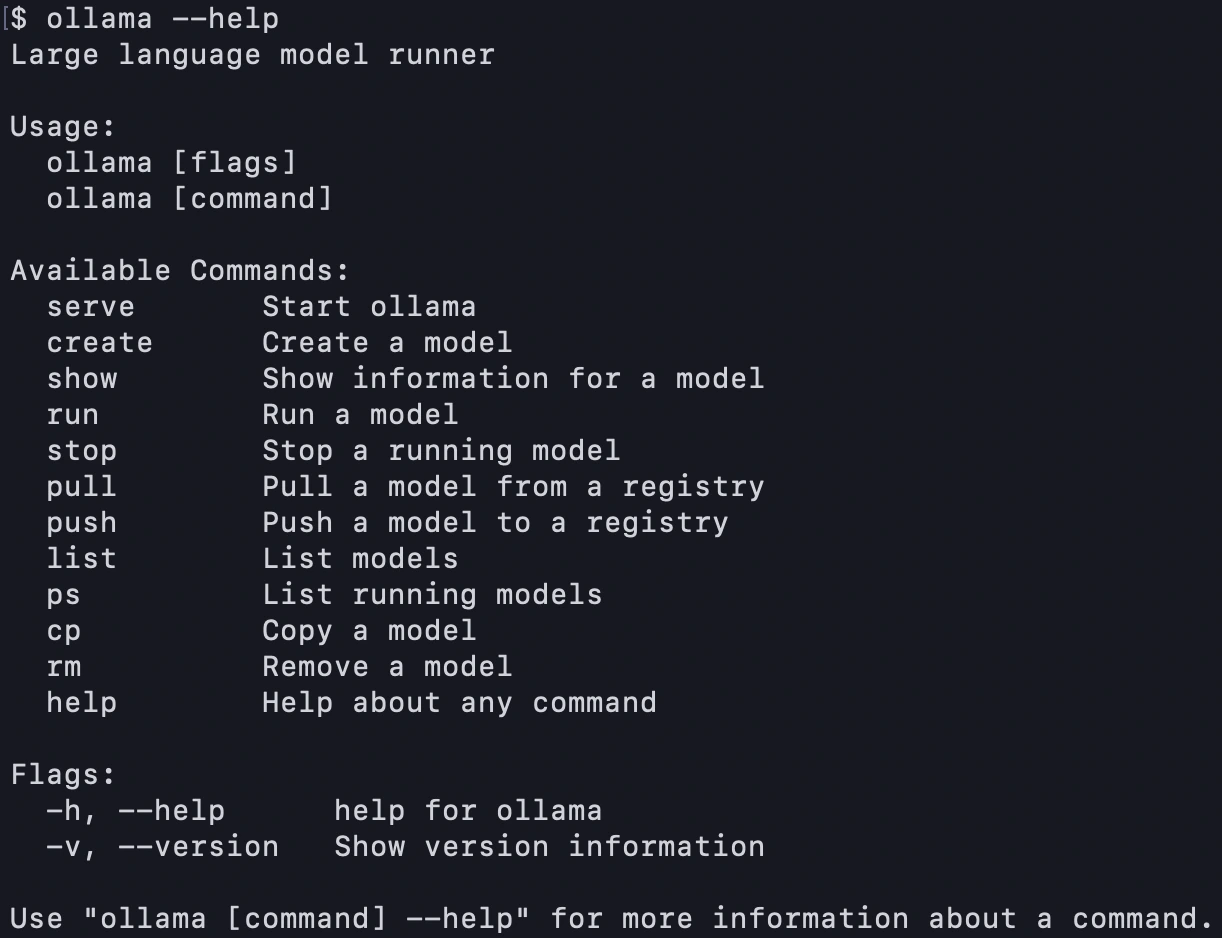

そしてターミナルを開くと、こちらもインストールが完了していることが分かります。

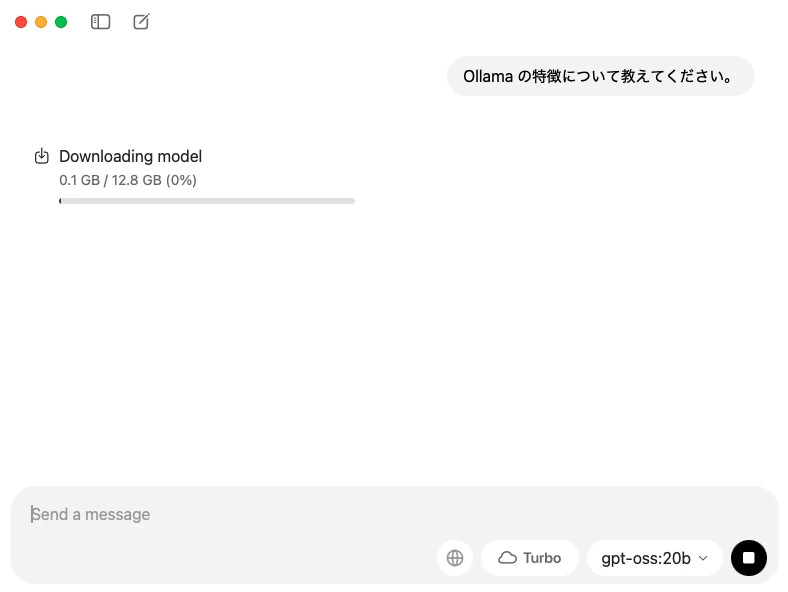

先ほどの画面の右下のモデル選択部分で「gpt-oss-20b」を選択し、そのままメッセージを送信します。すると必要なモデルのダウンロードが始まります。

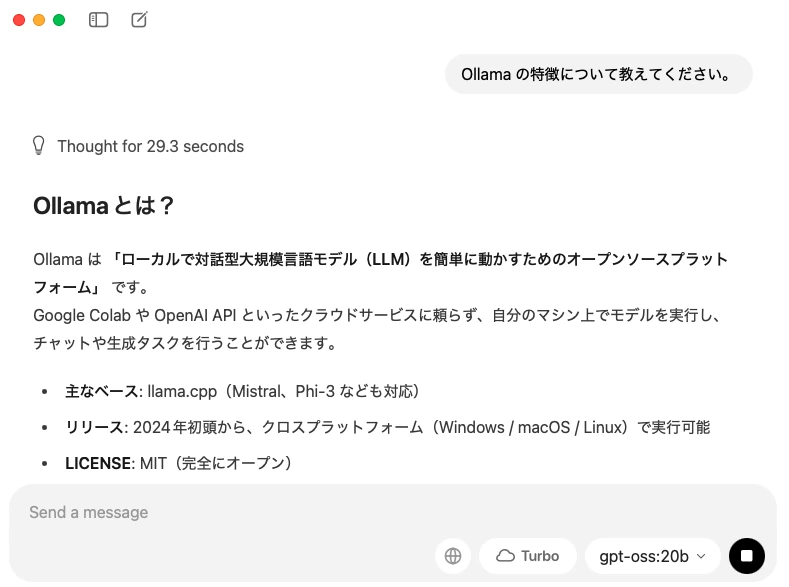

ダウンロードが完了すれば、先ほどのメッセージの回答を受け取ることができます。

Ollama は先述の通り、ローカルにAPIサーバーを立ててくれます。

このAPIはOpenAIに互換性のあるライブラリを提供しており、OpenAI Python SDK をそのまま利用することができます。

import openai

client = openai.OpenAI(

base_url = "http://localhost:11434/v1",

api_key="my-api-key", # str型なら何の値でもOK

)

response = client.chat.completions.create(

model="gpt-oss:20b",

messages=[

{"role": "system", "content": "あなたは優秀なアシスタントです。"},

{"role": "user", "content": "こんにちは、あなたについて教えてください。"},

]

)

print(response.choices[0].message.content)上記のコードを実行すると、以下の結果を受け取れました。

こんにちは!

私は**ChatGPT**、OpenAIが開発した大規模言語モデルです。

- 文章の生成・補完、質問への回答、情報整理、翻訳など、テキストに関するさまざまなタスクを行えます。

- 日常会話から専門的な話題まで幅広く対応できるように設計されています。

- 学習データは2023年11月までの情報を元にしていますが、リアルタイムの出来事や個人情報は持っていません。

何か知りたいことがあれば、遠慮なく聞いてくださいね!

これによって、ローカルLLMをAPI経由で簡単に検証できます。

Ollamaのようなプラットフォームを使えば、これらのモデルを簡単・安全・柔軟にローカル環境で活用できます。CLI・GUIの両方に対応し、LM StudioやvLLMと比較しても、導入しやすさと汎用性のバランスが取れている点は大きな強みです。

今後、gpt-ossとOllamaの組み合わせは、企業内PoCから本番運用まで幅広く対応できるローカルLLM構築の有力な選択肢になると考えられます。

株式会社Digeonでは、法人向けにChatGPTをセキュアに活用できる「ENSOUチャットボット」を提供しています。詳細はサービス紹介資料をご覧ください。

https://ensou.app/downloads/chatbot_overview/

また、お客様のクラウドやオンプレ環境に合わせたローカルLLM構築サービスを提供しています。ローカルAIの導入をご検討中の方は、ぜひお問い合わせください。

著者

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太