〒650-0035

兵庫県神戸市中央区浪花町64 三宮電電ビル 5階

目次

MCP(Model Context Protocol) は、Anthropic社が2024年11月に公開した、生成AI(LLM)とさまざまな外部システムを標準化して接続するための オープンプロトコル です。

このMCPがあることで、生成AIは様々なデータソースやシステムの機能などを容易に利用できるようになります。

本記事ではこのMCPについて、概念から活用方法まで解説していきます。

株式会社Digeonでは、法人向けの生成AIチャットボットである「ENSOUチャットボット」を提供しています。また、このENSOUチャットボットをお客様のクラウド環境やオンプレミス環境で動かす「ローカルLLM構築サービス」を提供しています。

MCPは、Anthropicが2024年11月に Introducing the Model Context Protocol という記事で提唱した、アプリケーションが大規模言語モデル(LLM)にコンテキストを提供する方法を標準化するオープンプロトコルです。

この記事の公表とともに、

の3つの技術が公開されました。

これまでLLMのモデル自体は能力的に進化してきたものの、データへのアクセスが制限されており、情報サイロやレガシーシステムによって孤立していました。そのため、新しいデータソースを利用するには都度カスタム実装が必要で、拡張性に欠けていました。MCPはこの課題を解決します。

こうした背景から Anthropic は MCP を公開し、システム・データ連携における煩雑さを解消し、LLM活用の幅をさらに広げようとしています。

その結果、Anthropic社が提唱したプロトコルですが、現在では競合であるOpenAI社もMCPによる連携をChatGPTアプリでサポートするなど、LLMをアプリケーションと連携させる上でのスタンダードになりつつあります。

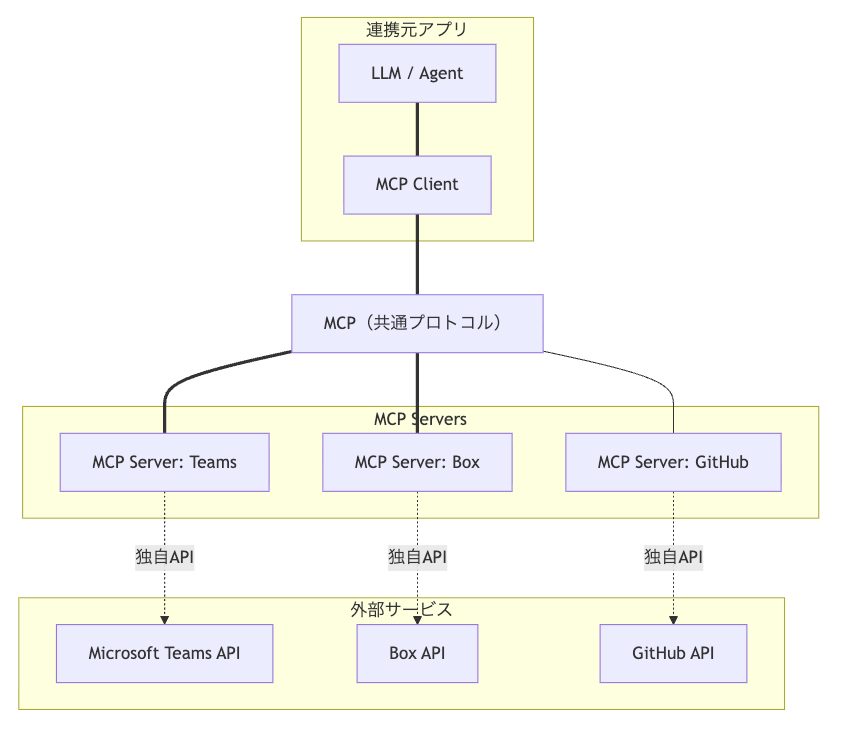

MCPは共通のプロトコルで外部サービスとLLMのやり取りをしやすくするために提唱されたプロトコルです。

MCPがない世界では、以下のように様々なツールと連携をするために、連携先ひとつひとつにAPIを呼び出すための実装を作り込む必要があります。

そこでMCPがある正解では以下のような状態を実現し、連携元のアプリはMCPに基づいた設定や実装を少しするだけで、様々なツールとMCPを介してやりとりができます。

先ほども紹介している通り、MCPはオープンプロトコルとして公開されており、Anthropicだけではなく様々な企業が自由に実装・利用することができます。

そのため、OpenAI、Google、Microsoftなど、既に様々な企業でMCPが活用されており、2025年時点での業界標準のプロトコルであると言っても過言ではありません。

OpenAI社が提供する ChatGPT にはMCP準拠の Connectors という機能が提供されており、様々な外部ツールとの連携が可能になっています。

基本的には管理者がコネクタとの接続の許可を出し、個々のユーザーが認証設定をすることで、外部ツールの認証認可制御に合わせたスコープでの連携が実現されています。

またMCP準拠のサーバーを構築することで、自社独自のシステムなどとも連携させることも可能です。

そしてこのコネクタで繋がった先のデータソースに関しては、DeepResearchや通常の検索機能としてデータ取得先として利用してくれるようになっており、例えばGmailを繋ぐことで「顧客名〜との直近のメールで返信し忘れているものは?」などの質問に対して、ChatGPTが返信漏れをリストアップしてくれるという使い方ができます。

ChatGPTの「組織設定 → コネクター」から、どのコネクタの利用を許可するかを管理者が設定します。

次に ユーザー毎の個人設定のコネクター から、ユーザー毎に連携先のアプリの認証等を実施します。

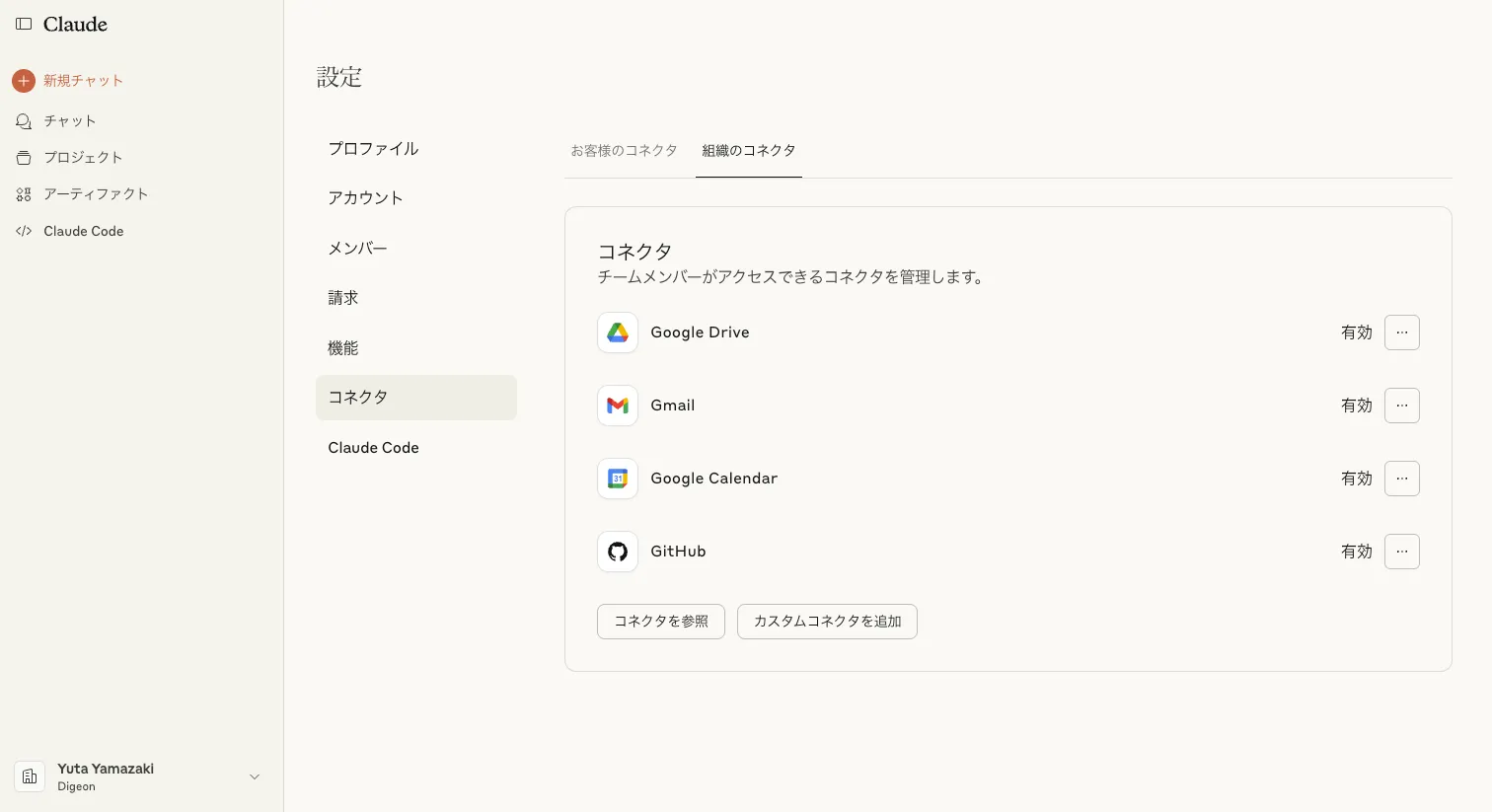

MCPを提唱した Anthropic 社が提供する Claude のWebアプリケーションでは、MCP連携機能が提供されています。

Anthropic社は2025年7月15日に Claude と外部ツールを連携させるMCP準拠の Connectors Directory を発表しました。

従来 Claude は、Web検索・Google Workspace 連携などの外部リソースを活用する機能や Integrations というMCP連携機能を提供していました。

この Connectors Directory を用いることで、NotionやCanvaなどのクラウドサービスだけでなく、Figmaなどのローカルで動くアプリケーションとも簡単に連携ができるようになりました。

Claudeでは組織のコネクタと個人の認証が近い画面で設定できます。

まずは「設定 → コネクタ → 組織のコネクタ」から、組織が許可する連携先アプリを設定します。

次に「設定 → コネクタ → 個人のコネクタ」から、自身が連携したいアプリの認証等を行います。

MCP(Model Context Protocol)は、生成AIと外部システムとの連携を標準化し、拡張性と柔軟性を飛躍的に向上させるプロトコルです。

Anthropicが提唱したこの仕組みは、今やOpenAIやGoogleといった他の主要プレイヤーにも採用され、2025年現在では業界標準の一角を占める存在になっています。

これまで煩雑だった各種ツールとの統合も、MCPにより簡易かつセキュアに実現可能となりました。特にChatGPTやClaudeなど主要なLLMプラットフォームでは、MCPを通じて組織レベルのシステムや個人のクラウドサービスまでを一元的に操作・連携する環境が整っています。

MCPの普及によって、生成AIは単なるテキスト生成の枠を超え、実用的な業務アシスタントや業務システムの中核としての可能性を持つようになりました。今後、より多くの企業や開発者がこのプロトコルを活用することで、生成AIの価値はさらに広がっていくでしょう。

株式会社Digeonでは、「Gemma 3」「gpt-oss」「Llama」などのLLMを、自社専用の安全な環境で活用したいお客様のために、 ローカルLLM構築サービス を提供しています。

ISMS認証取得企業によるセキュアな設計と、RAGやOCR、多言語対応などの豊富な機能を備えたAI活用基盤を、貴社の環境に合わせて構築します。

まず話を聞いてみたいという方は、以下のページからお問い合わせください。

またディジョンは、法人向けに ChatGPT をセキュアに使えるサービスである「ENSOUチャットボット」を提供しています。

サービス紹介資料をこちらからダウンロードいただけます👇

著者

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太