〒650-0035

兵庫県神戸市中央区浪花町64 三宮電電ビル 5階

目次

LM Studio は、Element Labs, Inc. が提供する、ローカルPCで大規模言語モデル(LLM)を簡単に実行できるデスクトップアプリケーションです。

オープンウェイトもしくはオープンソースのLLMのモデルをダウンロードして、対話をインターネット接続なしで実現できるアプリケーションであり、個人で手軽にオープンモデルを利用しやすいという特徴があります。

本記事では、LM Studioの概要から特徴、インストール方法、OpenAIのGPT-OSSをローカルで動かす手順までを解説します。社内データを外部に出さず、安全にAI活用を始めたい方は必見です。

ローカルLLM環境の構築にご興味をお持ちの方は、弊社の ローカルLLM構築サービス のページについてもご覧ください。

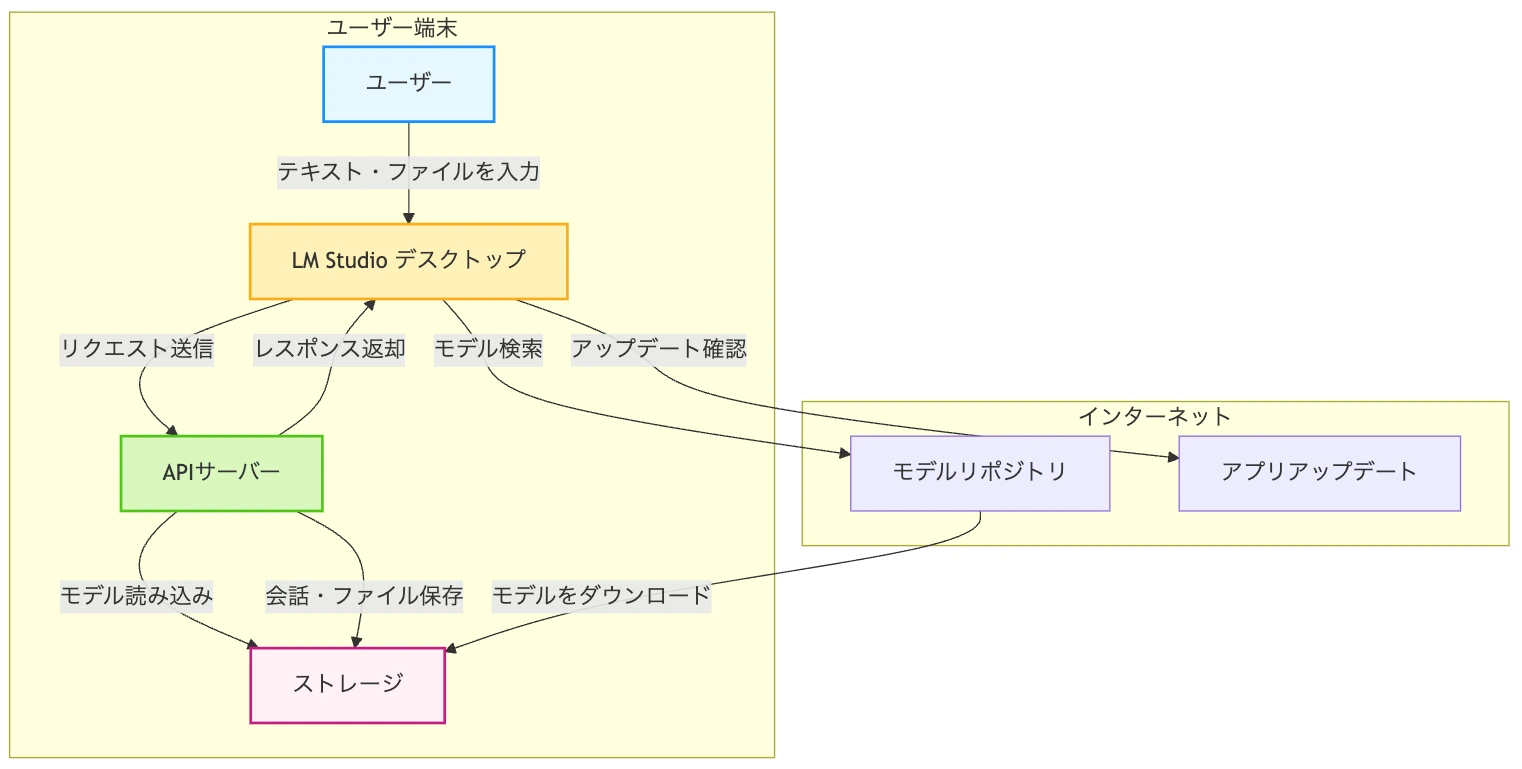

LM Studio はローカル端末でインターネット上からダウンロードしたモデルを、OpenAI社のAPI互換のAPIサーバーとして動かすことができるアプリケーションです。

主な機能・特徴としては、

があります。

このことから、チャットUIで様々なローカルで動作するLLMを検証できるだけでなく、PoCレベルであればこのアプリを使うだけでOpenAI互換のAPIサーバーとして、外部から利用することもできます。

類似製品であるOllamaとの比較記事を公開しています。詳しくはこちらも参照ください。

https://ensou.app/blog/local-llm-ollama-lm-studio-comparison/

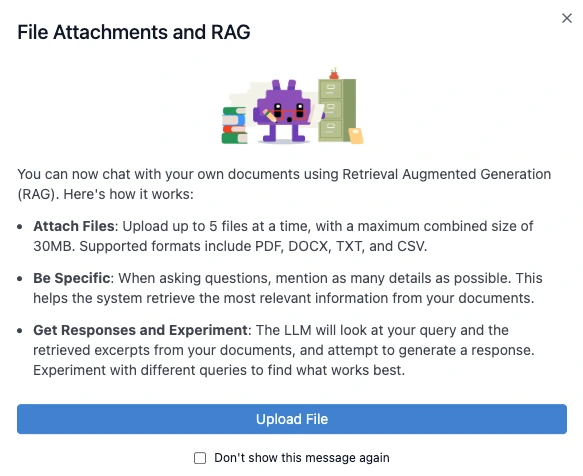

LM Studio はドキュメントを検索するRAG機能を提供しています。

ファイルは最大5つまで合計30MBまでアップロードでき、対応しているファイルはPDF、DOCX、TXT、CSVの4種類です。

また LM Studio では、ドキュメントのトークン数が小さければ全てをチャットのコンテキストに載せて、トークン数が大きい場合は自動的にRAGで検索するという仕組みを自動で使い分けています。

LM Studio の プライバシーポリシー では、インターネット接続のタイミングは、「AIモデルを検索するとき、またそれをダウンロードするとき」と「アプリ自体のアップデートがないかを確認するとき」に限定されていると明記されています。

この2つのタイミング以外ではインターネット接続は不要であり、またデータも全てローカルの端末上に保存されます。

そもそも LM Studio の仕組みとして、インターネット上からモデルをダウンロードし、そのダウンロードしたモデルをローカルの端末上で立てたサーバーで動かし、そことアプリ画面とで通信を行う仕組みを持っているため、ユーザーが入力したテキストやアップロードしたファイルが外部に流出することがありません。

LM Studio は様々なモデルを動かしてアプリケーションとして利用しやすい環境を提供してくれます。

一方でローカル端末で実行するというアプリケーションであるからこそ、動作させるのは軽量・高速なモデルが中心となり、ChatGPTから提供されている GPT-5 などに代表される先端のLLMよりは精度が至らないといった課題もあります。

また端末のスペックによっては、現実的に使えるモデルの選択肢がかなり限られる可能性も非常に高いということも起こりえます。

LM Studio は基本的に個人も企業も無料で利用できますが、SSOや管理者機能など必要に応じて、

の3つのプランを提供しています。

LM Studio のプラン・ライセンスについては、「LM Studio 職場でも無料で使える!プラン別機能・ライセンスについて徹底解説」で詳しく解説しています。

LM Studio はAPIサーバーの起動など開発者向けも機能も備えながら、一般ユーザー向けに簡単に使うことができるインターフェースも提供しています。今回は LM Studio を用いて、 gpt-oss-20b のモデルを動かしてみます。

GPT-OSS は 先日OpenAI社が発表したオープンウェイトなモデルのことで、 gpt-oss-20b と gpt-oss-120b の2つのモデルが提供されています。今回は手元のRAM 24GBのPCで試すので、 gpt-oss-20b の軽量版のモデルを使用します。

ここでは GPT-OSS に関する詳しい説明は省略します。詳細を知りたい方は、こちらの記事をご覧ください。

OpenAI GPT-OSS の実力を検証:高精度オープンLLMをローカル環境で安全・高速に活用する方法【LM Studio】 | ENSOU ブログ

まずは https://lmstudio.ai/ から、自身の端末・OSに合致するアプリケーションをダウンロードします。

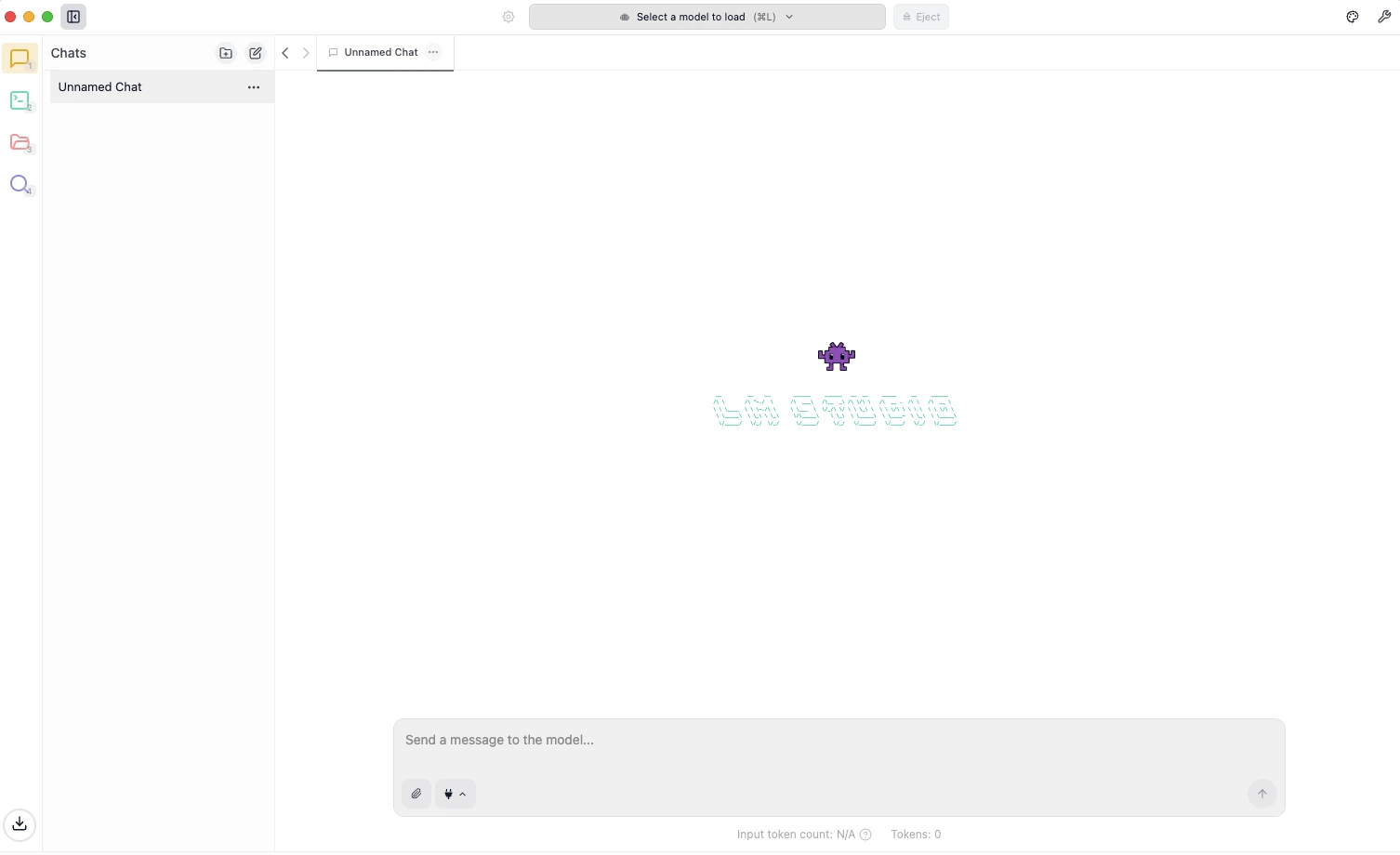

はじめはモデルのダウンロードが何もされてない状態から始まるため、ページ上部の「Select a model to load」をクリックします。

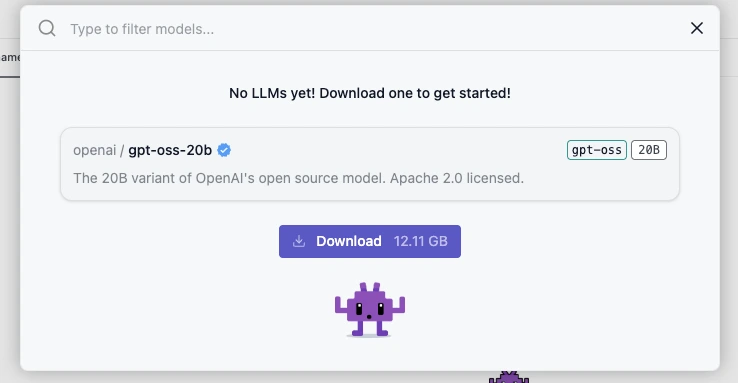

すると以下のような画面が現れます。今回は gpt-oss-20b を使用したいので、このままダウンロードボタンを押下します。20Bのモデルでも12GBほどのストレージ容量が必要になります。

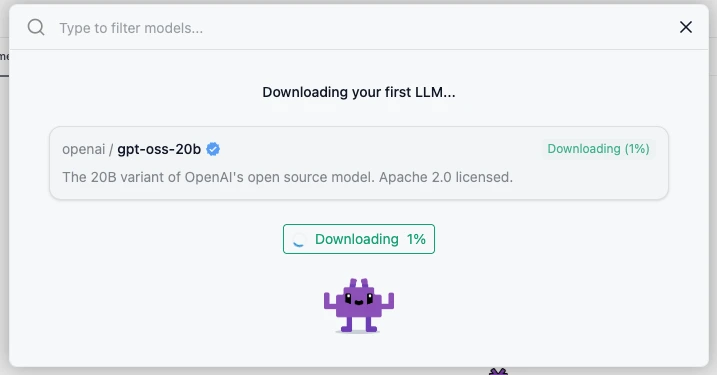

ダウンロードが完了するまでしばし待機します。

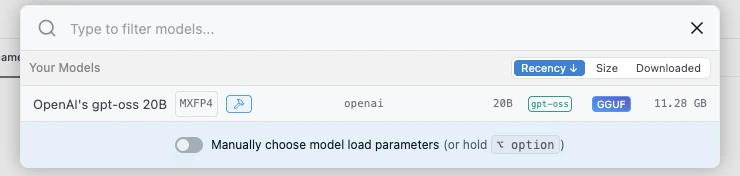

ダウンロードが完了すると、以下のような表示となり、 gpt-oss-20b を選択し、モデルをメモリに展開します。

モデル選択が完了すると、モデルがRAM上にロードされるまでしばらく待機します。gpt-oss-20b は12GBほどのメモリを使用するため、私の手元のMacBookPro(RAM: 24GB、2023年 M3チップ)では、数秒〜10秒ほどの時間がかかりました。

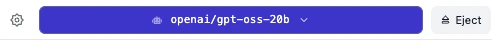

ロードが完了すると先ほどのアプリ上部がこのような表示になり、実際にチャットを開始できます。

ここからの使い方は ChatGPT や Gemini などと概ね同様です。

LM Studio は、ローカル環境でLLMを安全かつ簡単に動かせるオールインワンツールとして、個人から開発者まで幅広く活用できるアプリケーションです。

OpenAI互換APIやチャットUI、ドキュメント検索(RAG)など、検証からPoCレベルの開発までをネットワーク接続ほぼなしの単体で完結できる点が大きな強みです。

LM Studioは「まずはローカルLLMを試してみたい」「社内データを外部に出さず安全にAI検証を行いたい」というニーズに対し、最小限のセットアップで最大限の検証環境を提供してくれる有力な選択肢と言えるでしょう。

今回ご紹介したような GPT-OSS や Llama をはじめとするローカルLLMを、自社専用環境で安全かつ業務レベルで活用したい場合は、ぜひ弊社の ローカルLLM構築サービス をご検討ください。

弊社では、AIエージェント「ENSOUチャットボット」をはじめ、RAG、OCR、多言語対応など多機能な生成AI基盤をお客様の独自環境に構築し、セキュリティ認証(ISO/IEC 27001)に基づく安全な運用を支援いたします。

まずは気軽に相談したいという方は、以下のページからお問い合わせください。

著者

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太

山﨑 祐太